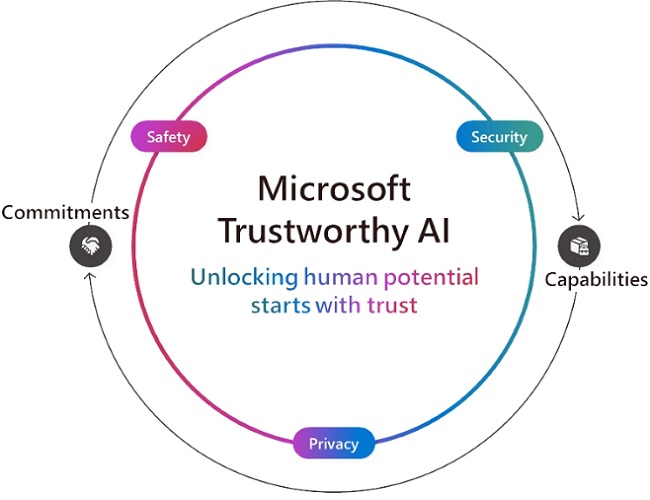

IA Confiável da Microsoft: desbloquear o potencial humano começa com confiança

Por Takeshi Numoto, vice-presidente executivo e diretor de marketing

À medida que a IA avança, todos nós temos um papel a desempenhar para desbloquear o impacto positivo da IA para organizações e comunidades em todo o mundo. É por isso que estamos focados em ajudar os clientes a usar e criar IA confiável, ou seja, uma IA segura, protegida e privada.

Na Microsoft, temos compromissos em garantir uma IA confiável e estamos criando tecnologia de suporte de ponta. Nossos compromissos e recursos andam de mãos dadas para garantir que nossos clientes e desenvolvedores estejam protegidos em todas as camadas.

Com base em nossos compromissos, estamos anunciando hoje novos recursos de produtos para fortalecer a segurança, proteção e privacidade dos sistemas de IA.

Segurança. A segurança é nossa principal prioridade na Microsoft, e nossa Iniciativa Futuro Seguro (SFI, em inglês) expandida ressalta os compromissos de toda a empresa e a responsabilidade que sentimos de tornar nossos clientes mais seguros. Esta semana, anunciamos nosso primeiro Relatório de Progresso da SFI, destacando atualizações que abrangem cultura, governança, tecnologia e operações. Isso cumpre nossa promessa de priorizar a segurança acima de tudo e é guiado por três princípios: seguro por design, seguro por padrão e operações seguras. Além de nossas ofertas primárias, Microsoft Defender e Purview, nossos serviços de IA possuem controles de segurança básicos, como funções internas para ajudar a evitar injeções imediatas e violações de direitos autorais. Com base neles, hoje estamos anunciando dois novos recursos: Além de nossas ofertas primárias, Microsoft Defender e Purview, nossos serviços de IA possuem controles de segurança básicos, como funções internas para ajudar a evitar injeções imediatas e violações de direitos autorais. Com base neles, hoje estamos anunciando dois novos recursos:

- Avaliações no Azure AI Studio para dar suporte a análises de risco proativas.

- O Microsoft 365 Copilot fornecerá transparência nas consultas da Web para ajudar administradores e usuários a entender melhor como a pesquisa na Web aprimora a resposta do Copilot. Disponível em breve.

Nossos recursos de segurança já estão sendo usados pelos clientes. A Cummins, uma empresa de 105 anos conhecida por sua fabricação de motores e desenvolvimento de tecnologias de energia limpa, recorreu ao Microsoft Purview para fortalecer sua segurança e governança de dados, automatizando a classificação, marcação e rotulagem de dados. A EPAM Systems, uma empresa de engenharia de software e consultoria de negócios, implantou o Microsoft 365 Copilot para 300 usuários por causa da proteção de dados que eles recebem da Microsoft. J.T. Sodano, Diretor Sênior de TI, compartilhou que "estávamos muito mais confiantes com o Copilot para Microsoft 365, em comparação com outros LLMs (grandes modelos de linguagem), porque sabemos que as mesmas políticas de proteção de dados e informações que configuramos no Microsoft Purview se aplicam ao Copilot."

Segurança. Incluindo segurança e privacidade, os princípios mais amplos de IA responsável da Microsoft, estabelecidos em 2018, continuam a orientar como criamos e implantamos IA com segurança em toda a empresa. Na prática, isso significa construir, testar e monitorar adequadamente sistemas para evitar comportamentos indesejáveis, como conteúdo prejudicial, viés, uso indevido e outros riscos não intencionais. Ao longo dos anos, fizemos investimentos significativos na construção da estrutura de governança, políticas, ferramentas e processos necessários para defender esses princípios e construir e implantar a IA com segurança. Na Microsoft, estamos comprometidos em compartilhar nossos aprendizados nesta jornada de defesa de nossos princípios de IA Responsável com nossos clientes. Usamos nossas próprias práticas recomendadas e aprendizados para fornecer às pessoas e organizações recursos e ferramentas para criar aplicativos de IA que compartilham os mesmos altos padrões pelos quais nos esforçamos.

Hoje, estamos compartilhando novos recursos para ajudar os clientes a buscar os benefícios da IA e, ao mesmo tempo, mitigar os riscos:

- Um recurso de correção na funcionalidade de detecção de grounding do Microsoft Azure AI Content Safety que ajuda a corrigir problemas de alucinação em tempo real antes que os usuários os vejam.

- Segurança de Conteúdo Embarcado, que permite que os clientes insiram o Azure AI Content Safety em dispositivos. Isso é importante para cenários no dispositivo em que a conectividade de nuvem pode ser intermitente ou indisponível.

- Novas avaliações no Azure AI Studio para ajudar os clientes a avaliar a qualidade e a relevância das saídas e a frequência com que seu aplicativo de IA gera material protegido.

- Detecção de material protegido para programação agora está em versão prévia no Azure AI Content Safety para ajudar a detectar conteúdo e código preexistentes. Esse recurso ajuda os desenvolvedores a explorar o código-fonte público em repositórios do GitHub, promovendo colaboração e transparência, ao mesmo tempo em que permite decisões de codificação mais informadas.

É incrível ver como os clientes de todos os setores já estão usando as soluções da Microsoft para criar aplicativos de IA mais seguros e confiáveis. Por exemplo, a Unity, uma plataforma para jogos 3D, usou o Microsoft Azure OpenAI Service para criar o Muse Chat, um assistente de IA que facilita o desenvolvimento de jogos. O Muse Chat usa modelos de filtragem de conteúdo no Azure AI Content Safety para garantir o uso responsável do software. Além disso, a ASOS, uma varejista de moda com sede no Reino Unido com quase 900 parceiros de marca, usou os mesmos filtros de conteúdo internos no Azure AI Content Safety para dar suporte a interações de alta qualidade por meio de um aplicativo de IA que ajuda os clientes a encontrar novos looks.

Também estamos vendo o impacto no espaço educacional. As Escolas Públicas da Cidade de Nova York fizeram parceria com a Microsoft para desenvolver um sistema de bate-papo seguro e apropriado para o contexto educacional, que agora estão testando nas escolas. O Departamento de Educação da Austrália do Sul também trouxe a IA generativa para a sala de aula com o EdChat, contando com a mesma infraestrutura para garantir o uso seguro para alunos e professores.

Privacidade. Os dados estão na base da IA, e a prioridade da Microsoft é ajudar a garantir que os dados do cliente sejam protegidos e compatíveis por meio de nossos princípios de privacidade de longa data, que incluem controle do usuário, transparência e proteções legais e regulatórias. Para desenvolver isso, hoje estamos anunciando:

- Inferência confidencial em versão prévia em nosso modelo Azure OpenAI Service Whisper, para que os clientes possam desenvolver aplicativos de IA generativa que dão suporte à privacidade verificável de ponta a ponta. A inferência confidencial garante que os dados confidenciais do cliente permaneçam seguros e privados durante o processo de inferência, que é quando um modelo de IA treinado faz previsões ou decisões com base em novos dados. Isso é especialmente importante para setores altamente regulamentados, como saúde, serviços financeiros, varejo, manufatura e energia.

- A disponibilidade geral de VMs Confidenciais do Azure com GPUs NVIDIA H100 Tensor Core, que permitem que os clientes protejam dados diretamente na GPU. Isso se baseia em nossas soluções de computação confidencial, que garantem que os dados do cliente permaneçam criptografados e protegidos em um ambiente seguro para que ninguém tenha acesso às informações ou ao sistema sem permissão.

- Azure OpenAI Data Zones para a União Europeia e os Estados Unidos estão chegando em breve e se baseiam na residência de dados existente fornecida pelo Azure OpenAI Service, facilitando o gerenciamento do processamento e armazenamento de dados de aplicativos de IA generativa. Essa nova funcionalidade oferece aos clientes a flexibilidade de dimensionar aplicativos de IA generativa em todas as regiões do Azure dentro de uma geografia, ao mesmo tempo em que lhes dá o controle do processamento e armazenamento de dados dentro da UE ou dos EUA.

Vimos um crescente interesse dos clientes em computação confidencial e entusiasmo por GPUs confidenciais, inclusive do provedor de segurança de aplicativos F5, que está usando VMs confidenciais do Azure com GPUs NVIDIA H100 Tensor Core para criar soluções avançadas de segurança baseadas em IA, garantindo a confidencialidade dos dados que seus modelos estão analisando. E a corporação bancária multinacional Royal Bank of Canada (RBC) integrou a computação confidencial do Azure em sua própria plataforma para analisar dados criptografados, preservando a privacidade do cliente. Com a disponibilidade geral de VMs confidenciais do Azure com GPUs NVIDIA H100 Tensor Core, o RBC agora pode usar essas ferramentas avançadas de IA para trabalhar com mais eficiência e desenvolver modelos de IA mais poderosos.

Alcance mais com IA confiável

Todos nós precisamos e esperamos por uma IA em que possamos confiar. Vimos o que é possível quando as pessoas são capacitadas para usar a IA de maneira confiável, desde enriquecer as experiências dos funcionários e remodelar os processos de negócios até reinventar o envolvimento do cliente e reimaginar nossas vidas cotidianas. Com novos recursos que melhoram a segurança, a proteção e a privacidade, continuamos a permitir que os clientes usem e criem soluções de IA confiáveis que ajudam todas as pessoas e organizações do planeta a alcançar mais. Em última análise, a IA confiável abrange tudo o que fazemos na Microsoft e é essencial para nossa missão, pois trabalhamos para expandir oportunidades, ganhar confiança, proteger direitos fundamentais e promover a sustentabilidade em tudo o que fazemos.